Wenn Künstliche Intelligenz Dinge „erfindet“

Was sind KI-Halluzinationen? Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht. Sie schreibt Texte, erstellt Bilder, generiert Videos und unterstützt Unternehmen bei Analyse-, Marketing- und Entscheidungsprozessen. Viele dieser Anwendungen wirken erstaunlich präzise, flüssig und überzeugend.

Doch genau hier liegt auch eine Gefahr. Denn was passiert, wenn eine KI Inhalte liefert, die logisch klingen, aber faktisch falsch sind? Wenn Quellen genannt werden, die nicht existieren? Oder wenn Zahlen, Namen oder Zusammenhänge schlicht erfunden werden?

Dieses Phänomen nennt man KI-Halluzinationen. Es gilt heute als eine der größten Herausforderungen moderner Sprachmodelle und generativer KI-Systeme. Besonders für Unternehmen, Agenturen und Organisationen kann das erhebliche Risiken mit sich bringen. (Quelle: MIT Technology Review, 2023; Nature, 2023)

Was sind KI-Halluzinationen genau?

Eine KI-Halluzination liegt vor, wenn ein Modell wie ChatGPT, Gemini (ehemals Bard) oder Claude falsche, unvollständige oder frei erfundene Inhalte erzeugt, die jedoch sprachlich korrekt und glaubwürdig wirken.

Wichtig ist: Die KI „lügt“ nicht bewusst. Sie hat kein Wissen im menschlichen Sinne. Stattdessen berechnet sie, welches Wort oder welcher Satz statistisch am wahrscheinlichsten auf den vorherigen folgt. Wahrheit oder Faktenprüfung sind dabei nicht automatisch Teil des Prozesses.

Das Ergebnis kann täuschend echt sein. Gerade deshalb werden Halluzinationen oft erst spät oder gar nicht erkannt. (Quelle: Stanford University – HAI, 2023; OpenAI Research Blog, 2023)

Warum halluzinieren KI-Systeme?

Die Ursachen liegen im grundlegenden Funktionsprinzip moderner Sprachmodelle. Diese Systeme werden mit Milliarden von Texten aus unterschiedlichsten Quellen trainiert. Dabei lernen sie Muster, Strukturen und Zusammenhänge zwischen Wörtern. Nicht jedoch, ob eine Aussage objektiv korrekt ist.

Halluzinationen entstehen besonders häufig, wenn:

- Trainingsdaten lückenhaft, widersprüchlich oder veraltet sind

- komplexe, mehrdeutige oder sehr spezifische Fragen gestellt werden

- das Modell „unter Druck“ gerät, unbedingt eine Antwort liefern zu müssen

- regionale oder lokale Informationen fehlen oder unterrepräsentiert sind

So kann eine KI etwa auf die Frage „Wie viele Start-ups gibt es in Berlin-Kreuzberg?“ eine konkrete Zahl nennen, selbst wenn es dazu keine belastbare Statistik gibt. Die Antwort klingt plausibel, ist aber nicht belegt. (Quelle: Harvard Business Review, 2023; Google DeepMind Blog, 2023)

Verlässlichkeit vs. Kreativität – ein schmaler Grat

Generative KI ist darauf optimiert, flüssige, verständliche und überzeugende Texte zu erzeugen. Genau das macht sie im Marketing, in der Kommunikation und im Storytelling so attraktiv.

Doch diese Stärke ist zugleich ihre Schwäche. Denn je besser ein Text klingt, desto weniger wird er hinterfragt. Fehler fallen oft nicht auf, vor allem dann, wenn Leserinnen und Leser kein Fachwissen haben.

Für Unternehmen in Berlin, die KI im Marketing, in Blogs oder auf Websites einsetzen, ist das besonders relevant. Inhalte müssen nicht nur kreativ sein, sondern auch korrekt, nachvollziehbar und vertrauenswürdig.

ThatWorksMedia Berlin setzt deshalb konsequent auf Faktenprüfung, Quellenarbeit und menschliche Redaktion, um KI sinnvoll und verantwortungsvoll einzusetzen. (Quelle: Forbes AI Insights, 2024; ThatWorksMedia Insights, 2024)

Typische Beispiele für KI-Halluzinationen

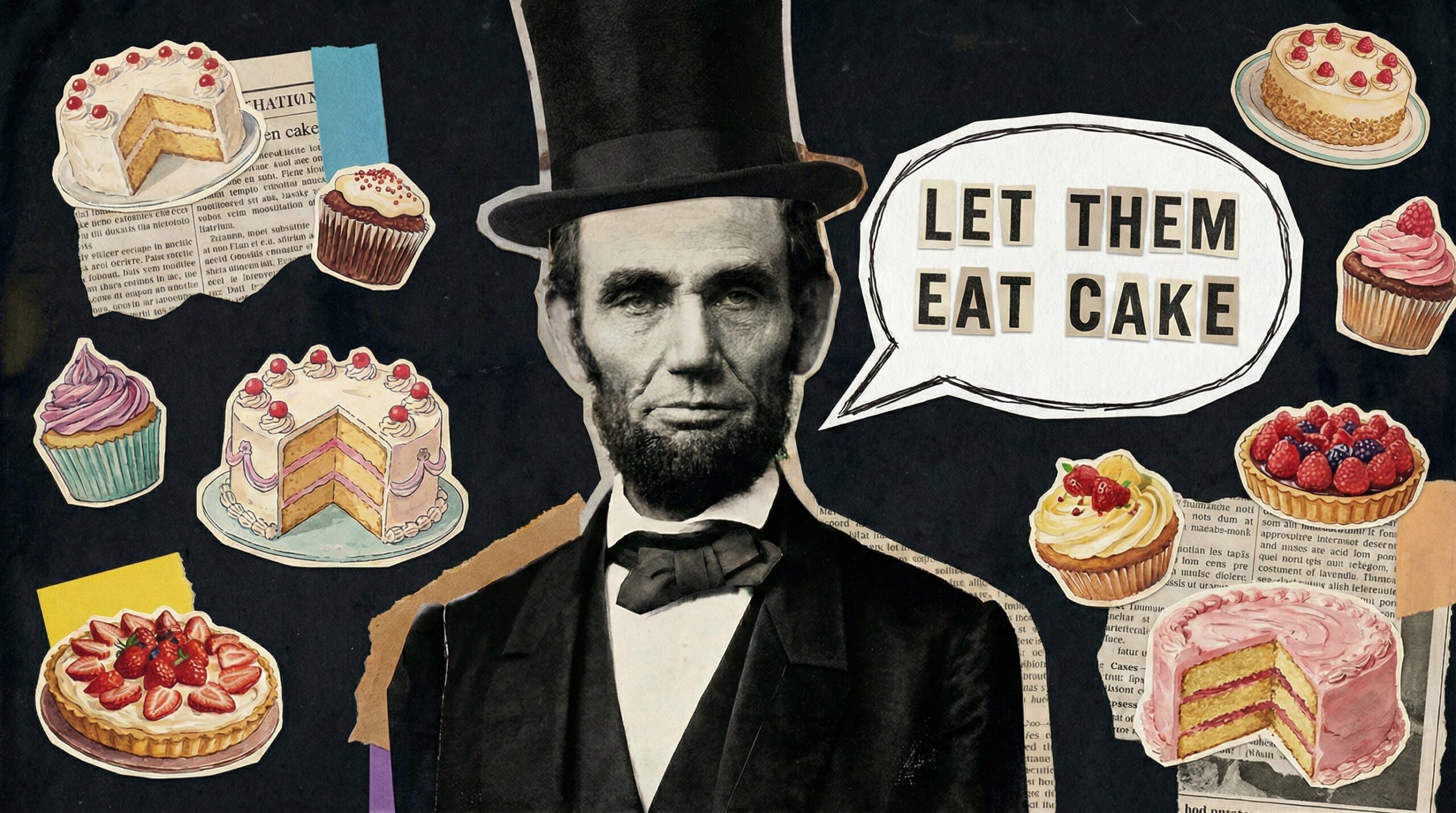

Dieses Zitat stammt nicht von Präsident Lincoln. Vermutlich nicht einmal vom eigentlich angeblichen Ursprung, die französische Königin Marie Antoinette.

KI-Halluzinationen treten in unterschiedlichen Formen auf. Zu den häufigsten gehören:

- Falsche Zitate: Aussagen werden realen Personen zugeschrieben, die sie nie getätigt haben

- Erfundene Quellen: Es werden existierende Magazine oder Studien genannt, aber mit fiktiven Artikeln

- Fehlerhafte Zahlen: Statistiken werden ohne Datenbasis generiert

- Veraltete Informationen: Entscheidungen oder Gesetze werden falsch dargestellt

- Scheinlogik: Aussagen wirken logisch, basieren aber auf falschen Annahmen

Besonders kritisch ist das in sensiblen Bereichen wie Recht, Gesundheit, Finanzen oder Journalismus. Hier können kleine Fehler große Folgen haben. (Quelle: Journal of Artificial Intelligence Research, 2023)

Wie lassen sich KI-Halluzinationen vermeiden?

Ganz verhindern lassen sich Halluzinationen derzeit nicht. Aber sie lassen sich deutlich reduzieren. ThatWorksMedia Berlin empfiehlt dafür einen mehrstufigen Ansatz:

1. Konsequente Quellenprüfung

KI-Outputs sollten immer mit verlässlichen Fachquellen abgeglichen werden.

2. Einsatz von Fact-Checking-Tools

Plattformen wie Google Scholar, Semantic Scholar oder CrossRef helfen, Studien und Veröffentlichungen zu überprüfen.

3. Sauberes Prompt-Engineering

Je klarer und strukturierter die Eingabe, desto geringer das Risiko spekulativer Antworten.

4. Human-in-the-Loop

Menschen bleiben die letzte Kontrollinstanz. KI unterstützt, sie ersetzt keine redaktionelle Verantwortung.

(Quelle: IBM Research, 2023; European AI Alliance, 2023)

Warum KI-Halluzinationen ein unternehmerisches Risiko sind

KI-Halluzinationen sind nicht nur ein technisches Problem. Sie sind vor allem ein organisatorisches und strategisches Risiko. Denn KI-generierte Inhalte fließen heute direkt in Entscheidungsprozesse ein, etwa in Marketingstrategien, Kundenkommunikation, Marktanalysen oder interne Reports.

Wenn falsche Informationen ungeprüft übernommen werden, kann das zu Fehlentscheidungen führen. Budgets werden falsch eingesetzt. Strategien basieren auf unzuverlässigen Annahmen. Oder Kundinnen und Kunden erhalten Inhalte, die Vertrauen kosten.

Gerade für Unternehmen in Berlin, die in einem wettbewerbsintensiven Umfeld agieren, ist Verlässlichkeit ein zentraler Erfolgsfaktor. KI darf Prozesse beschleunigen aber sie darf sie nicht entkoppeln von Verantwortung und Kontrolle.

ThatWorksMedia Berlin empfiehlt deshalb, KI nicht isoliert einzusetzen, sondern sie klar in bestehende Unternehmensprozesse einzubetten. Dazu gehören definierte Freigaben, klare Zuständigkeiten und transparente Dokumentation. Nur so bleibt nachvollziehbar, wie Inhalte entstehen und auf welcher Basis Entscheidungen getroffen werden.

(Quelle: PwC AI Governance Report, 2024; BSI – KI und Verantwortung, 2023)

Zukunftsperspektive: Wie KI lernt, weniger zu halluzinieren

Forschungsinstitute und Tech-Unternehmen arbeiten intensiv an Lösungen. Auch in Berlin, etwa beim DFKI, entstehen neue Ansätze zur Reduktion von Halluzinationen.

Besonders relevant sind:

- Retrieval-Augmented Generation (RAG)

- verifizierungsbasierte Modelle

- externe Wissensdatenbanken in Echtzeit

Diese Systeme kombinieren Kreativität mit überprüfbaren Daten und machen KI-Ausgaben transparenter und belastbarer. (Quelle: DFKI Research Report, 2024; Meta AI Research, 2024)

Fazit: KI ist mächtig – aber nicht unfehlbar

KI-Halluzinationen zeigen deutlich: Moderne KI kann beeindrucken, aber sie ist kein Ersatz für kritisches Denken. Wer KI strategisch einsetzen will, braucht klare Prozesse, Qualitätskontrollen und Verantwortung.

Für Unternehmen in Berlin bedeutet das: KI ist ein Werkzeug, kein Autopilot.

ThatWorksMedia Berlin unterstützt dabei, KI-Content sicher, glaubwürdig und SEO-stark einzusetzen. Ohne Risiken für Marke oder Reputation.

FAQ: Häufige Fragen zu KI-Halluzinationen

1. Können KI-Halluzinationen vollständig vermieden werden?

Nein. Aber sie lassen sich durch Technik, Prozesse und menschliche Kontrolle stark reduzieren.

2. Sind alle KI-Modelle gleich anfällig?

Nein. Größere Modelle mit besserem Kontext halluzinieren seltener, aber nie gar nicht.

3. Warum spricht man von „Halluzinationen“?

Weil die KI Informationen „erkennt“, die faktisch nicht existieren.

4. Wie gefährlich sind Halluzinationen für Unternehmen?

Sie können zu Reputationsschäden, rechtlichen Problemen und Fehlentscheidungen führen.

5. Wie hilft ThatWorksMedia Berlin konkret?

Durch KI-Strategie, Content-Qualität, SEO-Know-how und klare Kontrollprozesse.

ThatWorksMedia Berlin – Ihre Agentur für intelligente, faktenbasierte KI-Kommunikation